根据最新的ISACA研究,尽管工作场所对人工智能(AI)的使用不断增加,但只有三分之一的组织在充分解决安全、隐私和道德风险方面做得到位。

调查显示,只有34%的数字信任专业人士认为组织对AI的道德标准足够重视,而不到三分之一(32%)的人表示组织在部署AI方面足够解决了关注的问题,比如数据隐私和偏见。

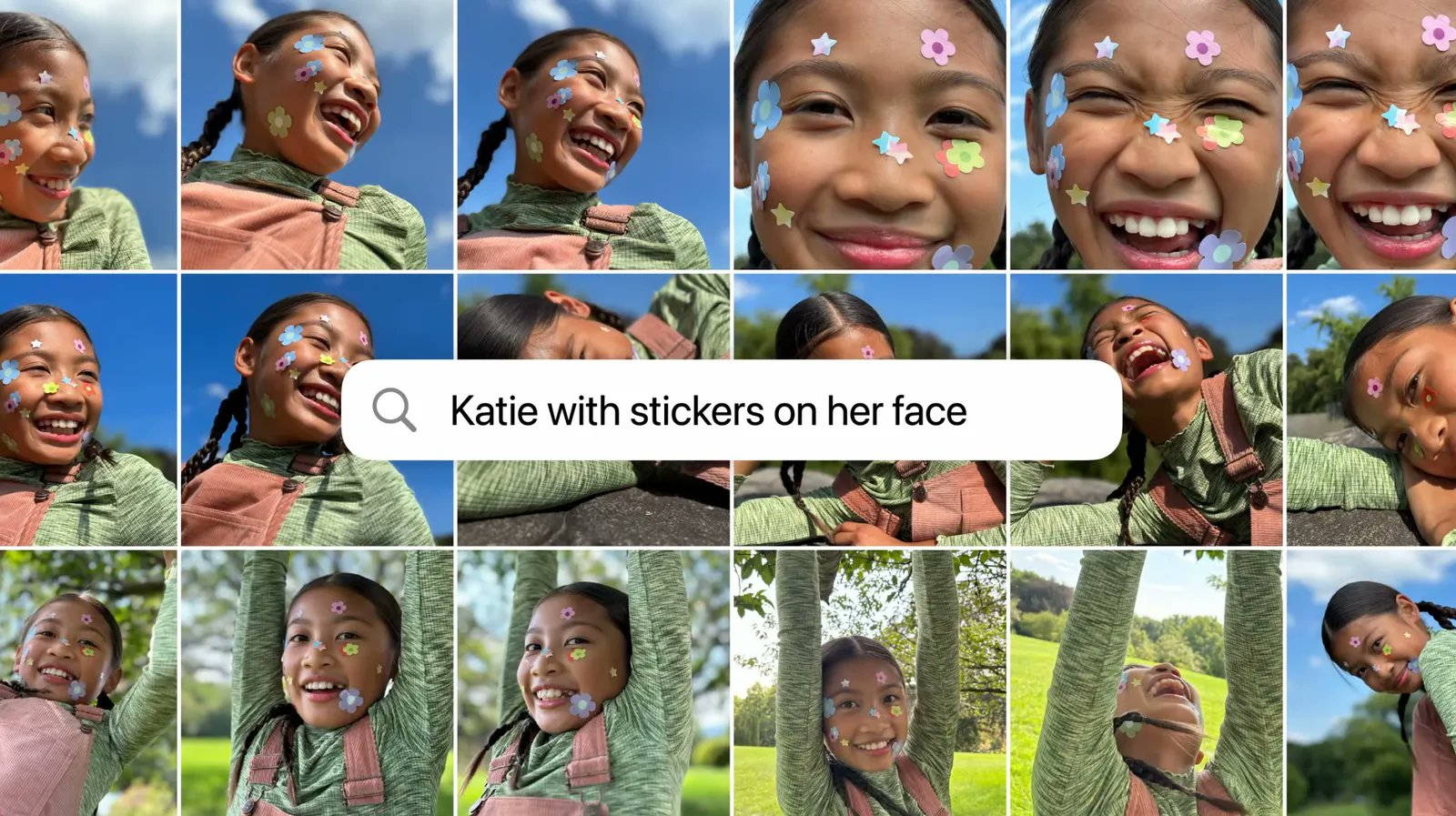

尽管60%的受访者表示,他们所在组织的员工在工作中使用生成式AI工具,但只有70%的人表示员工使用了任何类型的AI。

42%的组织现在正式允许在工作场所使用生成式AI,比六个月前的28%有所增加。

根据受访者的说法,目前AI最常见的三种用途是提高生产力(35%)、自动化重复性任务(33%)和创建书面内容(33%)。

此外,该研究发现数字信任专业人员对人工智能了解不足,只有25%的人自认为对AI非常熟悉或非常了解,将近一半(46%)的人在涉及AI时自称为初学者。

85%的人承认,他们需要在未来两年内增加在这一领域的技能和知识,以提升或保住自己的工作。

然而,大多数组织没有采取措施解决IT专业人员和普通员工对AI知识的缺乏,40%的组织根本不提供AI培训,32%的受访者表示提供的培训仅限于从事技术相关职位的员工。

此外,只有15%的组织有正式的、全面的政策来管理AI技术的使用。

ISACA前董事会主席、Cybral董事会成员罗伯·克莱德表示,这与AI的专业知识和培训不足直接相关。

克莱德建议组织利用可用的AI框架来制定AI治理政策,比如美国国家标准与技术研究所(NIST)的AI风险管理框架。他还建议组织至少建立一些明确的规则来管理AI的使用,比如不将机密信息输入公共大型语言模型(LLMs)。

此外,ISACA还推出了三门新的在线AI培训课程,包括审计和管理这些技术。

调查显示,IT专业人员认为AI将对工作产生重大影响,大约一半(45%)的人认为在未来五年中,许多工作将因为AI而被淘汰,80%的人认为许多工作将因此而改变。然而,78%的人认为AI对他们自己的职业将产生中性或积极的影响。

克莱德认为,AI最终将取代某些网络安全角色,例如SOC分析师。但他也认同绝大多数受访者的观点,即AI将对网络安全工作产生积极影响,创造出许多与工作场所中AI的安全使用相关的新角色。

调查还显示,受访者对恶意行为者使用AI工具攻击组织的担忧。超过五分之四(81%)的人认为虚假信息/误导性信息是最大的威胁。但令人担忧的是,只有20%的IT专业人员表示他们对自己能够检测到AI驱动的虚假信息有信心,23%的人对公司有此信心。